1.fr, un outil d’audit et d’optimisation rédactionnelle

1.fr est un outil qui va vous aider à optimiser le contenu textuel de vos pages (websemantique). Il analyse et émet des recommandations pour vous guider dans votre optimisation.

Si une page tente de se positionner dans les moteurs de recherches sur l’expression « référencement local », 1.fr simulera l’analyse que pourrait en faire un moteur de recherche et proposera des modifications susceptibles de rendre l’article plus pertinent et riche pour les moteurs de recherche pour cette requête.

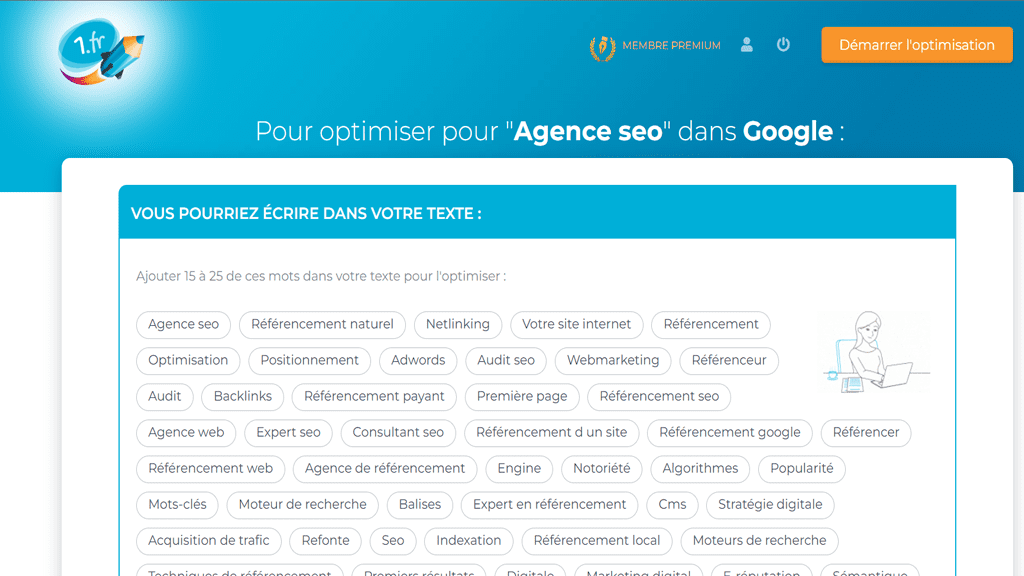

Le fonctionnement est très simple, vous rentrez l’url de la page à optimiser puis l’expression ciblée. 1.fr vous propose ensuite un rapport de ce type (reprise de l’exemple ci-dessous) :

Une fois ce rapport en mains, on peut commencer par identifier si la page est correctement optimisée pour l’expression ciblée. Il est possible en cliquant sur le champ lexical concerné d’obtenir des suggestions de termes à intégrer dans son contenu pour rendre sa page plus riche.

On peut également identifier les autres champs lexicaux présents sur la page. De cette façon, il est possible de repérer des champs lexicaux parasites (hors sujet) qui risquent de rendre votre contenu moins « spécifique » et donc potentiellement plus complexe à évaluer pour l’algorithme de Google. En cliquant sur ces derniers, vous obtenez en plus des exemples de termes à enlever afin de diminuer le poids du champ lexical en question.

Comment l’outil détermine-t-il les champs lexicaux ?

1.fr a analysé les champs lexicaux et positionnements dans les moteurs de recherche de millions de pages francophones. La conclusion met en évidence que les pages les mieux classées contiennent généralement un champ lexical plus étoffé sur l’expression visée, comparativement aux pages de classement inférieur.

Fort de cette observation, 1.fr propose donc un service d’optimisation des champs lexicaux. Concrètement, si votre objectif est de positionner une page sur l’expression « agence SEO » ou « SEO », 1.fr vous indiquera si votre champ lexical « SEO » est satisfaisant, ou comment le modifier en conséquence pour le renforcer.

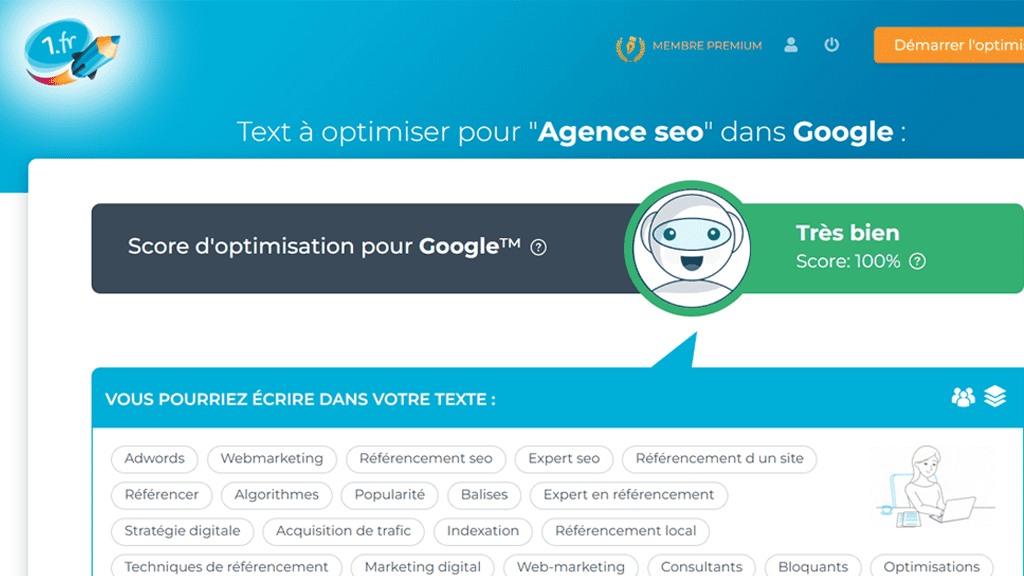

Une fois l’optimisation terminée. Le champ lexical visé sera le premier de la page en termes de poids et assez riche pour tenir la comparaison vis-à-vis des pages concurrentes.

Pour ce faire, les expressions de la page sont comparées et regroupées par affinité. Exemple : il y a affinité entre « pomme » et « compote », mais pas entre « pomme » et « plaquette de frein ». Ainsi, il y a extraction des différents champs lexicaux que compose la page. Les champs lexicaux extraits sont des regroupements des expressions qui sont en rapport étroit sur un thème précis.

Exemple : le champ « pomme » pourra contenir « compote », « fruits », « pommier », « récolte »…

Lors d’une rédaction de contenu, un rédacteur, pour cibler une requête précise, cela implique la rédaction d’un texte riche comprenant un champ lexical riche et exhaustif autour de la requête ciblée. 1.fr est une aide précieuse lors de cette étape, car il fournit alors une vue précise des champs lexicaux d’une page : le champ lexical visé (et les coocurences intéressantes pour le renforcer), mais également les champs lexicaux parasites qui peuvent être présents (et les termes à supprimer du texte pour avoir un résultat global plus cohérent et facilement interprétable pour un robot).